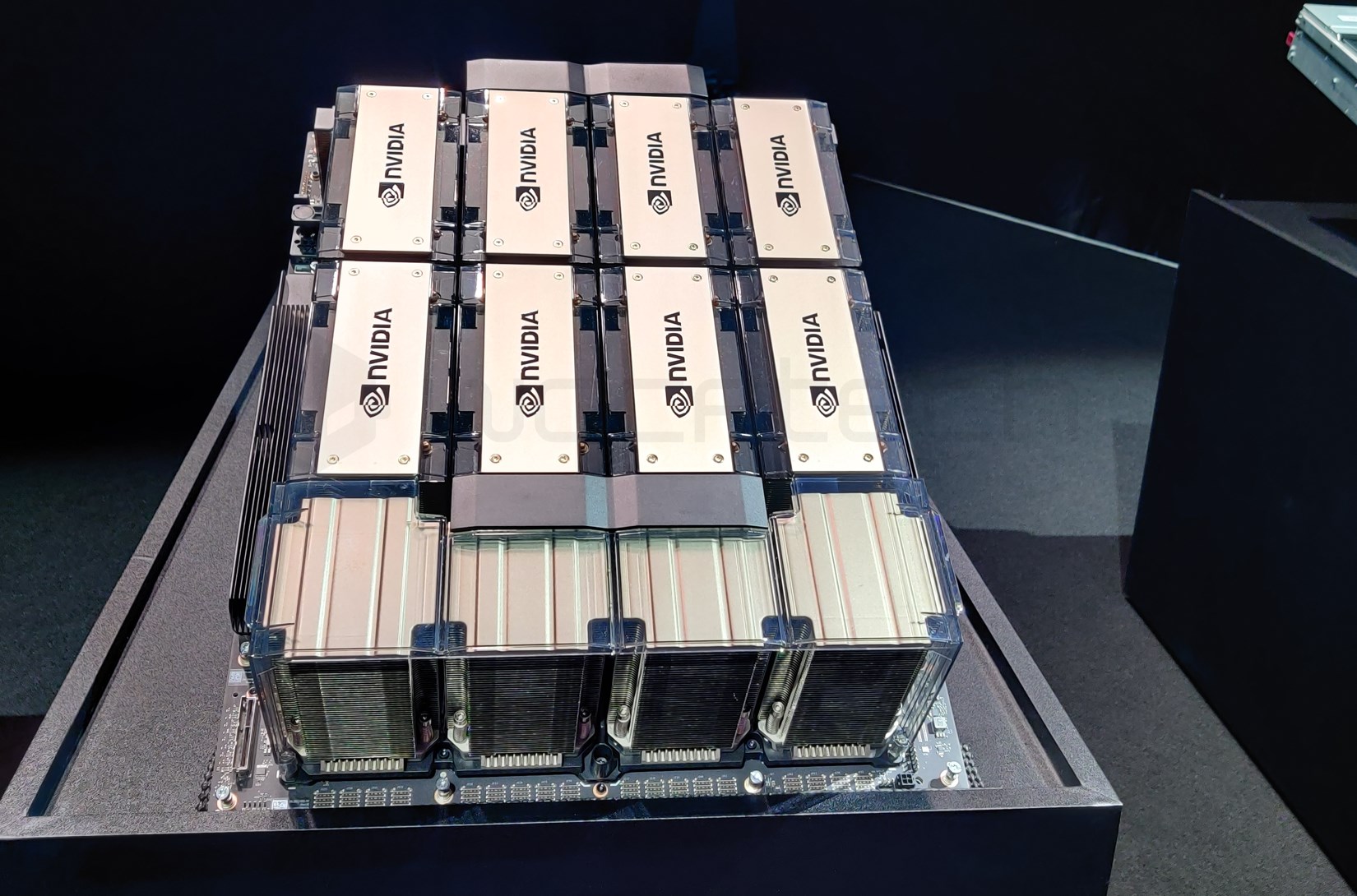

OpenAI estaria desenvolvendo um modelo de inteligência artificial avançado que interconecta 10 milhões de GPUs da NVIDIA.

A disputa para obter o controle da Inteligência Artificial está acelerando, com perfis de hardware e software tentando ultrapassar um ao outro. Neste contexto, a NVIDIA e a OpenAI estão trabalhando em um modelo de IA que unifica não milhares mas milhões de GPUs.

OpenAI e NVIDIA estariam trabalhando juntas para criar um modelo de GPU AI que concluísse todos os modelos de Inteligência Artificial.

Até o presente, a NVIDIA e a OpenAI desenvolveram conjuntamente o ChatGPT, cujo último modelo GPT-4 se baseia em milhares de unidades de processamento gráfico de IA da NVIDIA. É informado que a NVIDIA forneceu cerca de 20.000 de suas novas GPUs de IA à OpenAI, as quais serão acrescidas nos próximos meses. No entanto, esta é apenas a ponta do iceberg.

A AMD está trabalhando para melhorar as características de overclocking da GPU “OverDrive” para os usuários do Linux.

Segundo Wang Xiaochuan, o empresário e criador do motor de busca chinês Sogou, o ChatGPT está trabalhando em um modelo de computação AI mais avançado que possui métodos de treinamento mais desenvolvidos. Esta versão da tecnologia é capaz de ligar 10 milhões de GPUs AI em conjunto.

Alcançar um número de até 100.000 GPUs é um grande objetivo, no entanto, o número de um milhão de GPUs de Inteligência Artificial resulta ainda mais ambicioso. Para incrementar a sua credibilidade, Wang investiu numa nova empresa de inteligência para a China conhecida como Baichuan Intelligence, destinada a ser um rival principal da OpenAI no país. Destaca-se que a mesma empresa acabou de lançar o seu modelo de linguagem Baichuan-13B que é capaz de executar no hardware de consumidor como a GPU NVIDIA GeForce RTX 3090. Contudo, a possibilidade de OpenAI se tornar uma força hegemônica no futuro também é levantada e, por isso, ele sugere que a China possui necessidade urgente de um OpenAI próprio.

A OpenAI tem uma visão massiva de seu projeto, que exigiria 10 milhões de GPUs de IA para alimentar seus futuros modelos de idioma. No entanto, dada a capacidade atual da NVIDIA, só seria possível produzir um milhão de GPUs AI, o que levaria 10 anos para cumprir tal projeto.

A NVIDIA está trabalhando com o TSMC para aumentar o número de unidades produzidas, o que pode aumentar significativamente em breve. No entanto, há alguns obstáculos, como os custos, a capacidade e, o mais importante, a forma de conectar muitas GPUs juntas. Embora seja apenas um sonho, se forem construídos milhões de sistemas alimentados por GPUs AI, seria uma realização tecnológica impressionante.

MyDrivers, que é uma fonte de notícias, oferece atualizações de dados.